Integración de Modelos (MCP/Agent)¶

Este artículo le presenta cómo integrar FIRERPA con modelos de lenguaje grandes (LLMs) (a través de MCP o comandos). FIRERPA ya ha implementado en su capa base el protocolo de servidor MCP y la funcionalidad nativa de tool-call de OpenAI, lo que le permite escribir sus propios plugins MCP y ofrecer servicios a través del puerto estándar 65000, o heredar la clase Agent para implementar llamadas a tools de forma totalmente automática.

Comando Agent Integrado¶

Mediante el comando agent integrado, puede completar rápidamente tareas de forma totalmente conversacional a través de un modelo de lenguaje grande. Es compatible con cualquier proveedor de servicios o servicio autohospedado que sea compatible con la API de OpenAI + toolcall. En combinación con el crontab integrado, puede programar la ejecución de tareas conversacionales.

Sugerencia

| Nombre del Parámetro | Tipo | Requerido | Valor por Defecto | Descripción |

|---|---|---|---|---|

--api | Cadena (str) | Sí | - | Endpoint de la API |

--model | Cadena (str) | Sí | - | Nombre del modelo |

--temperature | Flotante (float) | No | 0.2 | Temperatura de muestreo del modelo |

--key | Cadena (str) | Sí | - | Clave de API para autenticación |

--vision | Booleano (bool) | No | False | Habilitar modo de visión |

--imsize | Entero (int) | No | 1000 | Tamaño de la imagen en modo de visión |

--prompt | Cadena (str) | Sí | - | Instrucción a ejecutar por el agente (Agent) |

--max-tokens | Entero (int) | No | 16384 | Número máximo de tokens a generar |

--step-delay | Flotante (float) | No | 0.0 | Tiempo de retraso entre pasos |

Atención

Una vez que tenga la información necesaria, puede hacer que la IA opere su dispositivo automáticamente ingresando el siguiente comando en la terminal del escritorio remoto.

agent --api https://generativelanguage.googleapis.com/v1beta/openai/chat/completions --key YOUR_API_KEY --model gemini-2.5-flash --prompt "Ayúdame a abrir la aplicación de configuración, nombre del paquete com.android.settings, encontrar la configuración de red y activar el modo avión"

Si su prompt de tarea es demasiado largo, también puede proporcionarlo a través de un archivo.

agent --api https://generativelanguage.googleapis.com/v1beta/openai/chat/completions --key YOUR_API_KEY --model gemini-2.5-flash --prompt /path/to/prompt.txt

Integración con Claude & Cursor (MCP)¶

Esta sección le presenta cómo integrar la funcionalidad MCP de FIRERPA en su cliente de modelo de lenguaje grande. Solo hemos proporcionado ejemplos para Claude y Cursor, pero puede usarlo en cualquier otro lugar que admita el protocolo MCP.

Nota

Atención

Instalar la Extensión Oficial¶

Le proporcionamos un servicio MCP oficial. Puede descargar este módulo de extensión en extensions/firerpa.py. También puede consultar su método de implementación para escribir o ampliar la funcionalidad del plugin usted mismo. Después de descargar el script del plugin de extensión, súbalo al directorio /data/usr/modules/extension del dispositivo a través del escritorio remoto o manualmente con push. Luego, reinicie el dispositivo o el servicio FIRERPA.

Atención

Usar la Extensión Oficial¶

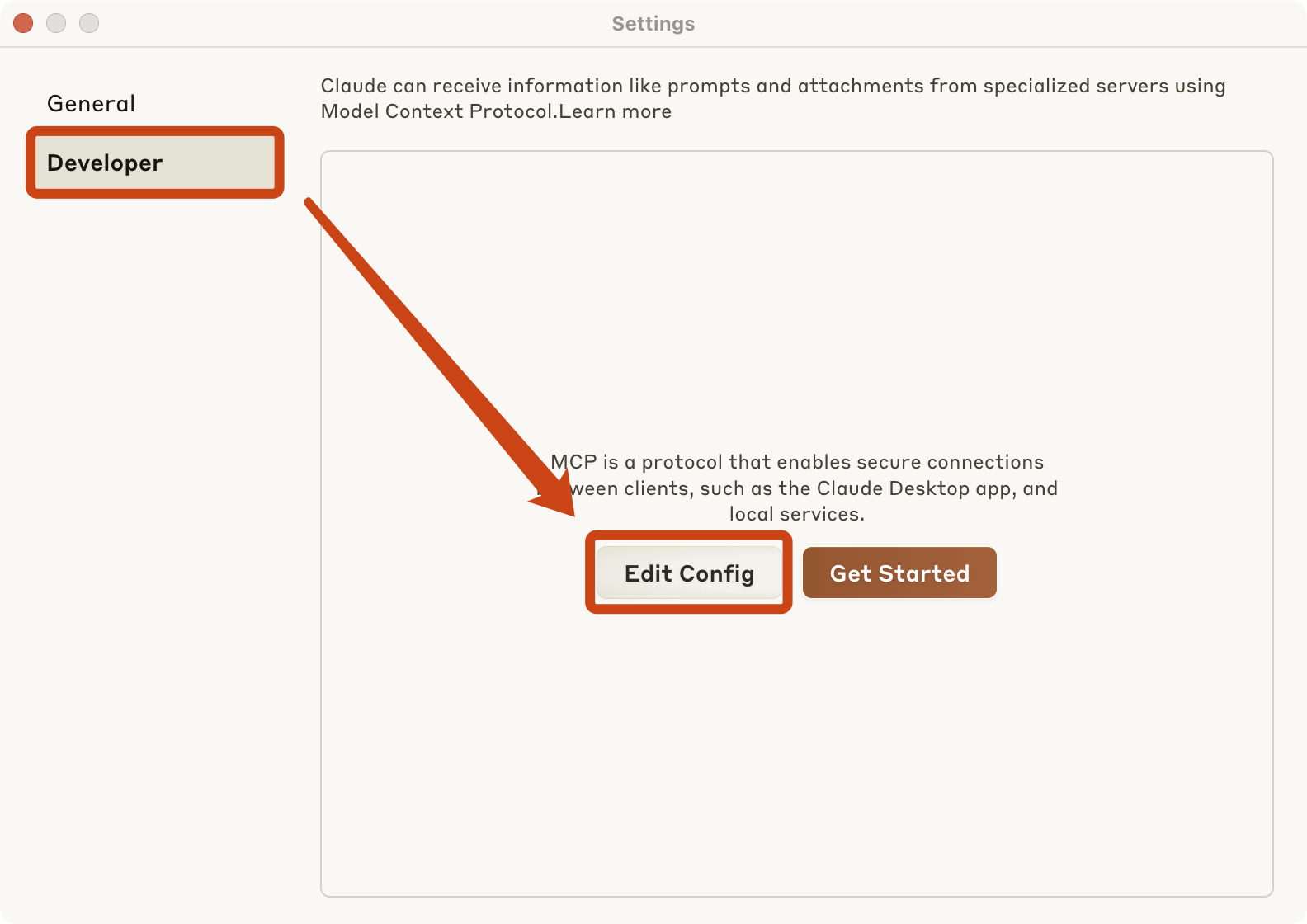

Para Claude, primero debe ir a la página de configuración de Claude y seguir los pasos que se muestran en la imagen a continuación. Luego, según las indicaciones, edite el archivo de configuración claude_desktop_config.json de Claude y agregue la siguiente configuración de servicio MCP en formato JSON.

{"mcpServers": {"firerpa": {"command": "npx", "args": ["-y", "supergateway", "--streamableHttp", "http://192.168.0.2:65000/firerpa/mcp/"]}}}

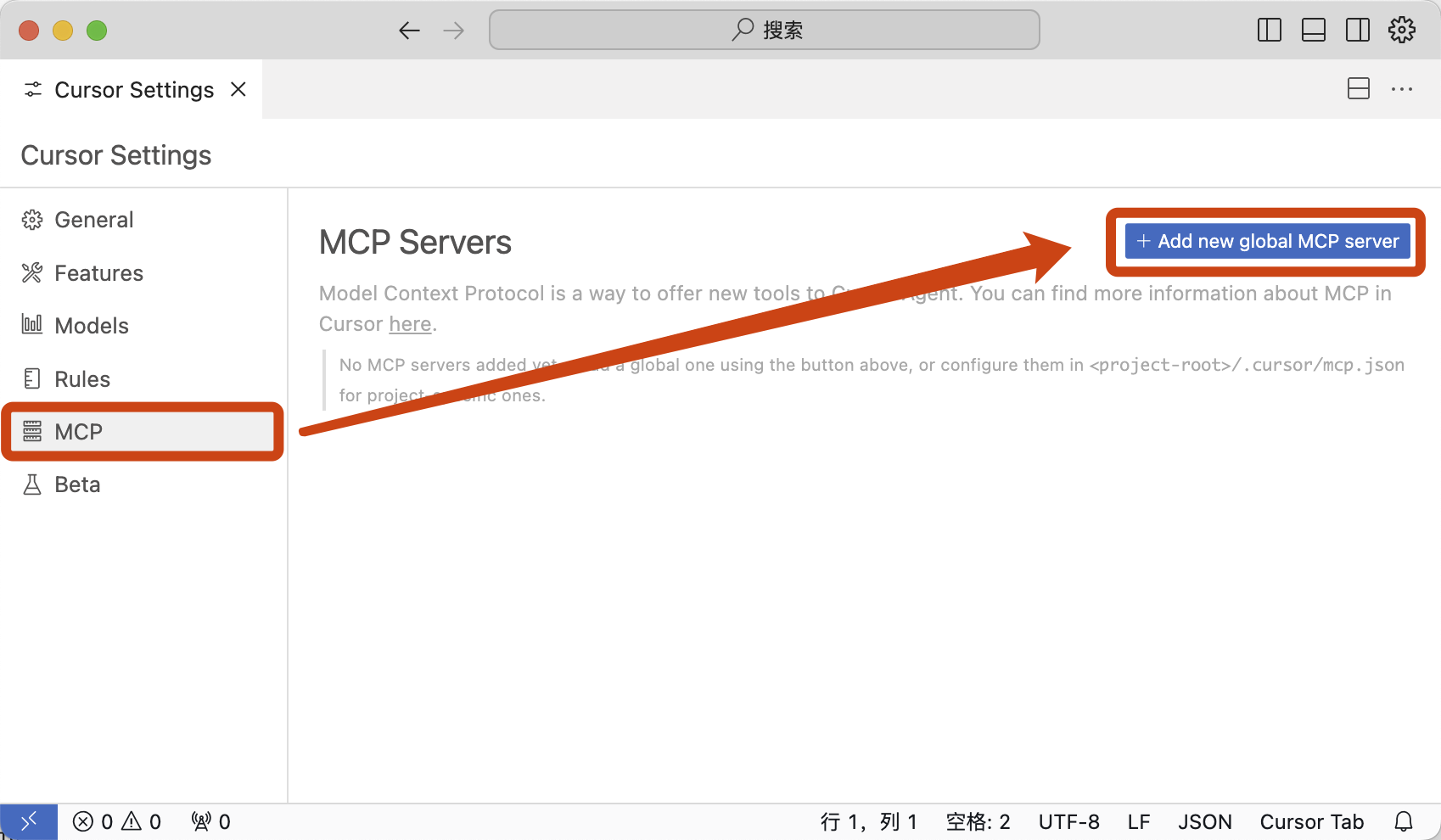

Para Cursor, debe abrir la configuración de Cursor (Cursor Settings), seguir los pasos que se muestran en la imagen e ingresar la siguiente configuración.

{"mcpServers": {"firerpa": {"url": "http://192.168.0.2:65000/firerpa/mcp/"}}}

Atención

Escribir Extensiones MCP¶

Sugerencia